人工 知能 は 人間 を 超える か Chapter 04 (2)

じんこう|ちのう||にんげん||こえる||chapter

Will Artificial Intelligence Surpass Humans Chapter 04 (2)

L'intelligence artificielle dépassera-t-elle l'homme ? Chapitre 04 (2)

A inteligência artificial ultrapassará o ser humano Capítulo 04 (2)

実際 に サポートベクターマシン の 精度 は 高く 、 よく 用い られて きた 。

じっさい||||せいど||たかく||もちい||

In fact, the accuracy of the support vector machine has been high and has been widely used.

ただし 、 大きな データ を 対象 と した とき は 、 計算 に 時間 が かかって しまう と いう 欠点 も ある 。

|おおきな|でーた||たいしょう|||||けいさん||じかん||||||けってん||

However, it also has the disadvantage that it takes a long time to calculate when targeting large data.

いま まで の 方法 が 、 純粋に 機械 学習 の 分ける と いう 「 機能 」 を エレガントな 方法 で 実現 しよう と して いる の に 対し 、 ニューラルネットワーク は 、 人間 の 脳 神経 回路 を まね する こと に よって 分けよう と いう もの である 。

|||ほうほう||じゅんすいに|きかい|がくしゅう||わける|||きのう||えれがんとな|ほうほう||じつげん|||||||たいし|||にんげん||のう|しんけい|かいろ|||||||わけよう||||

The methods used so far are purely machine learning "functions" of sorting. Neural networks, on the other hand, attempt to divide the brain by mimicking the neural circuits of the human brain.

人間 の 脳 は ニューロン ( 神経 細胞 ) の ネットワーク で 構成 さ れて いて 、 ある ニューロン は ほか の ニューロン と つながった シナプス から 電気 刺激 を 受け取り 、 その 電気 が 一定 以上 たまる と 発火 して 、 次の ニューロン に 電気 刺激 を 伝える 。

にんげん||のう|||しんけい|さいぼう||ねっとわーく||こうせい||||||||||||||でんき|しげき||うけとり||でんき||いってい|いじょう|||はっか||つぎの|||でんき|しげき||つたえる

The human brain is made up of a network of neurons (nerve cells), and one neuron receives an electrical stimulus from a synapse connected to another neuron, and when that electricity builds up above a certain level, it fires and sends electricity to the next neuron. Communicate the stimulus.

これ を 数学 的に 表現 する と 、 ある ニューロン が ほか の ニューロン から 0 か 1 の 値 を 受け取り 、 その 値 に 何らか の 重み を かけて 足し 合わせる 。

||すうがく|てきに|ひょうげん||||||||||||あたい||うけとり||あたい||なんらか||おもみ|||たし|あわせる

Mathematically, one neuron receives a value of 0 or 1 from another neuron, and that value is multiplied by some weight and added together.

それ が ある 一定 の 閾値 を 超える と 1 に なり 、 超え なければ 0 に なる 。

|||いってい||いきち||こえる||||こえ|||

If it exceeds a certain threshold, it becomes 1, and if it does not exceed it, it becomes 0.

それ が また 次の ニューロン に 受け渡さ れる と いう 具合 である 。

|||つぎの|||うけわたさ||||ぐあい|

The next neuron is then passed on to the next one, and so on.

ニューラルネットワーク を モデル 化 した の が 次 ページ の 図 15 で 、 各 ノード が シナプス を 模して いる 。

||もでる|か||||つぎ|ぺーじ||ず||かく|||||もして|

Figure 15 on the next page models a neural network, with each node simulating a synapse.

下 の 層 の ニューロン から 受け取った 値 を かけ合わせ 、 その 和 を シグモイド 関数 に かけて 出力 する 。

した||そう||||うけとった|あたい||かけあわせ||わ|||かんすう|||しゅつりょく|

Multiplies the values received from the neurons in the lower layer and outputs the sum to the sigmoid function.

シグモイド 関数 は 「 オン ・ オフ 」 を 数学 的に 扱い やすい ように する ため の 関数 で 、 この 場合 は 0・1 な ので 、 ほとんど 発火 して い ない ( オフ ) 状態 である 。

|かんすう||おん|おふ||すうがく|てきに|あつかい||||||かんすう|||ばあい|||||はっか||||おふ|じょうたい|

The sigmoid function is a function to make "on / off" mathematically easy to handle. In this case, it is 0.1, so it is in a state where it hardly fires (off).

つまり 、 次の ニューロン へ の 影響 は 小さい 。

|つぎの||||えいきょう||ちいさい

In other words, the effect on the next neuron is small.

一連の 流れ の 中 で 肝 と なる の は 重み づけ で 、 人間 の ニューロン が 学習 に よって シナプス の 結合 強度 を 変化 さ せる ように 、 学習 する 過程 で 重み づけ を 変化 さ せ 、 最適な 値 を 出力 する ように 調整 する こと で 、 精度 を 高めて いく 。

いちれんの|ながれ||なか||かん|||||おもみ|||にんげん||||がくしゅう|||||けつごう|きょうど||へんか||||がくしゅう||かてい||おもみ|||へんか|||さいてきな|あたい||しゅつりょく|||ちょうせい||||せいど||たかめて|

The key to the flow is weighting, and the weighting is changed in the learning process so that human neurons change the synaptic connection strength by learning, and the optimum value is output. By adjusting in this way, the accuracy will be improved.

たとえば 、 こんな 問題 だ 。

||もんだい|

For example, here is the problem.

自分 の 出身 地 の 飲食 店 の 良し 悪し を 学習 する プログラム を つくる 人 も いれば 、 自分 が 好きな アイドル の 画像 を 判定 さ せよう と する 人 まで さまざまだ 。

じぶん||しゅっしん|ち||いんしょく|てん||よし|わるし||がくしゅう||ぷろぐらむ|||じん|||じぶん||すきな|あいどる||がぞう||はんてい|||||じん||

Some people have programs to learn the good and bad of restaurants in their hometown, while others try to determine the image of an idol they like.

これ まで 、 機械 学習 の 分野 は 、 自然 言語 処理 、 構造 化 さ れた データ 、 画像 や 音声 など の マルチメディア 、 ロボット など の 領域 で 研究 さ れて きた 。

||きかい|がくしゅう||ぶんや||しぜん|げんご|しょり|こうぞう|か|||でーた|がぞう||おんせい|||まるちめでぃあ|ろぼっと|||りょういき||けんきゅう|||

To date, the field of machine learning has been studied in areas such as natural language processing, structured data, multimedia such as images and voice, and robots.

中でも 、 ウェブ の 登場 以降 は 、 自然 言語 処理 と 機械 学習 が がっちり タッグ を 組んで 進んで きた 印象 が ある 。

なかでも|||とうじょう|いこう||しぜん|げんご|しょり||きかい|がくしゅう|||||くんで|すすんで||いんしょう||

Above all, I have the impression that natural language processing and machine learning have been firmly teamed up since the advent of the Web.

ところが 、 最近 の ブレークスルー は 、 画像 認識 の 分野 から 起こった 。

|さいきん||||がぞう|にんしき||ぶんや||おこった

However, recent breakthroughs have come from the field of image recognition.

したがって 、 ここ で は 画像 に おける 機械 学習 を 例 に とって みよう 。

||||がぞう|||きかい|がくしゅう||れい|||

Therefore, let's take machine learning in images as an example.

よく 使わ れる 例 が 手書き 文字 認識 である 。

|つかわ||れい||てがき|もじ|にんしき|

A common example is handwriting recognition.

手書き 文字 認識 と は 何かと いう と 、 郵便 局 の 郵便 番号 の 自動 読み取り で 使わ れる ような もの だ 。

てがき|もじ|にんしき|||なにかと|||ゆうびん|きょく||ゆうびん|ばんごう||じどう|よみとり||つかわ||||

What is handwriting recognition? It's like being used in the automatic reading of postal codes at post offices.

図 16 の 左 下 の 図 の ように 、 同じ 「3」 でも ゆがんだり 曲がったり 、 伸びたり 縮んだり して いる が 、 人間 なら この 程度 の 表記 の ゆらぎ は 難なく 「3」 だ と 判別 できる だろう 。

ず||ひだり|した||ず|||おなじ|||まがったり|のびたり|ちぢんだり||||にんげん|||ていど||ひょうき||||なんなく|||はんべつ||

As shown in the lower left figure of Fig. 16, the same "3" is distorted, bent, stretched, and shrunk, but humans can easily determine that this degree of fluctuation in the notation is "3".

ところが 、 これ が コンピュータ に は 難しい 。

|||こんぴゅーた|||むずかしい

However, this is difficult for computers.

どういう 画像 なら 「3」 で 、 どういう 画像 なら 「8」 な の か 、 あるいは 「5」 な の か 、 と いう こと を 明示 的に ルール と して 与える こと は 難しい から である 。

|がぞう||||がぞう|||||||||||||めいじ|てきに|るーる|||あたえる|||むずかしい||

This is because it is difficult to explicitly give a rule as to what kind of image is "3" and what kind of image is "8" or "5".

手書き 文字 を 正しく 認識 できる ように なる ため の 訓練 用 データ と して 、0 から 9 まで の 10 個 の 数字 を いろいろな 手書き 文字 で 表現 した MNIST と いう データ セット が ある 。

てがき|もじ||まさしく|にんしき||||||くんれん|よう|でーた||||||こ||すうじ|||てがき|もじ||ひょうげん||mnist|||でーた|せっと||

There is a data set called MNIST that expresses 10 numbers from 0 to 9 in various handwritten characters as training data to enable correct recognition of handwritten characters.

画像 認識 の 世界 で は よく 使わ れる 標準 的な もの だ 。

がぞう|にんしき||せかい||||つかわ||ひょうじゅん|てきな||

It is a standard that is often used in the world of image recognition.

この データ セット で は 、 一つひとつ の 手書き 数字 は 28 ピクセル ×28 ピクセル =784 ピクセル の 画像 と なって いる ( 画像 の データ と して は とても 小さい )。

|でーた|せっと|||ひとつひとつ||てがき|すうじ||||||がぞう||||がぞう||でーた|||||ちいさい

In this data set, each handwritten digit is a 28 x 28 = 784 pixel image (very small for image data).

この 画像 が 7万 枚 あって 、 それぞれ どの 数字 に 該当 する の か と いう 正解 ラベル が つけ られて いる 。

|がぞう||よろず|まい||||すうじ||がいとう||||||せいかい|らべる||||

There are 70,000 of these images, each labeled with the correct answer as to which number it corresponds to.

この 画像 を ピクセル 単位 に 分解 して ニューラルネットワーク に 読み 込ま せる 。

|がぞう|||たんい||ぶんかい||||よみ|こま|

This image is decomposed into pixel units and loaded into the neural network.

入力 層 と 出力 層 の 間 に ある の が 隠れ 層 であり 、 入力 さ れた データ は 、 入力 層 から 隠れ 層 、 隠れ 層 から 出力 層 へ と 出力 さ れる 。

にゅうりょく|そう||しゅつりょく|そう||あいだ|||||かくれ|そう||にゅうりょく|||でーた||にゅうりょく|そう||かくれ|そう|かくれ|そう||しゅつりょく|そう|||しゅつりょく||

Between the input and output layers is the hidden layer, and the input data is output from the input layer to the hidden layer and from the hidden layer to the output layer.

ニューラルネットワーク の 出力 層 で は 、0 から 9 まで に 対応 する 10 個 の ニューロン が あり 、 それぞれ 値 が 出力 さ れる 。

||しゅつりょく|そう||||||たいおう||こ||||||あたい||しゅつりょく||

In the output layer of the neural network, there are 10 neurons corresponding to 0 to 9, each of which outputs a value.

図 の 場合 は 、「3」 である 確率 が 「0・40」 と なって 一 番 高い ので 、 この 手書き 文字 は 「3」 である と 判定 する こと に なる 。

ず||ばあい|||かくりつ||||ひと|ばん|たかい|||てがき|もじ||||はんてい||||

In the case of the figure, "3. The probability of being "0.40" is The handwritten letter is "3" because it is the highest. The decision will be based on the following criteria.

なぜなら 別々の データ を 使って いる と 、 よい アルゴリズム が できた の か 、 たまたま データ が よかった だけ な の か 、 わから ない から だ 。

|べつべつの|でーた||つかって||||||||||でーた||||||||||

Because if you use different data, you don't know if you have a good algorithm or if you just happened to have good data.

そして 、 学習 を する 方法 、 テスト を する 方法 に ついて も 、 標準 的な やり 方 が ある 。

|がくしゅう|||ほうほう|てすと|||ほうほう||||ひょうじゅん|てきな||かた||

There is also a standardized method of learning and testing.

エムニスト の データ を 使って 学習 する 際 は 、 たとえば 「3」 の 画像 を 入力 し 、 もし 間違って 「8」 と 判定 した 場合 は 、「 入力 層 」 と 「 隠れ 層 」 を つなぐ 部分 の 重み の 、「 隠れ 層 」 と 「 出力 層 」 を つなぐ 部分 の 重み の の 値 を 変えて 、 正しい 答え が 出る ように 調整 を 加える 。

||でーた||つかって|がくしゅう||さい||||がぞう||にゅうりょく|||まちがって||はんてい||ばあい||にゅうりょく|そう||かくれ|そう|||ぶぶん||おもみ||かくれ|そう||しゅつりょく|そう|||ぶぶん||おもみ|||あたい||かえて|ただしい|こたえ||でる||ちょうせい||くわえる

When learning using the data of the emnist, for example, if you enter an image of "3" and mistakenly judge it as "8", the weight of the part connecting the "input layer" and the "hidden layer", " Change the value of the weight of the part that connects the "hidden layer" and the "output layer", and make adjustments so that the correct answer is obtained.

要するに 、1 つ 前 の 図 15 の 重み づけ の 数字 ( 図 中 で 楕円 で 示した 数字 ) を 少しずつ 変化 さ せて 、 正しい 答え に なる ように 調整 する のだ 。

ようするに||ぜん||ず||おもみ|||すうじ|ず|なか||だえん||しめした|すうじ||すこしずつ|へんか|||ただしい|こたえ||||ちょうせい||

In short, the weighted numbers in Figure 15 (the numbers shown by the ellipses in the figure) are changed little by little and adjusted to give the correct answer.

この 重み づけ は 、 いって みれば 、 ニューロン 同士 を つなぐ 線 の 太 さ である 。

|おもみ||||||どうし|||せん||ふと||

This weighting is, so to speak, the thickness of the line connecting the neurons.

この 線 の 数 は とても 多く 、 隠れ 層 が 仮に 100 個 だ と する と 、784×100+100×10 で 合計 約 8万 個 ある 。

|せん||すう|||おおく|かくれ|そう||かりに|こ||||||ごうけい|やく|よろず|こ|

The number of these lines is very large, and if there are 100 hidden layers, there are 784 × 100 + 100 × 10, for a total of about 80,000.

この 膨大な 数 の 重み づけ を 変えれば 、 切り取ら れる 空間 の 形 が 変わる 。

|ぼうだいな|すう||おもみ|||かえれば|きりとら||くうかん||かた||かわる

Changing the weighting of this enormous number changes the shape of the space to be cut out.

その うち の 、 ある 切り取り 方 が 、 数字 の 「3」 を 表す こと に なる 。

||||きりとり|かた||すうじ|||あらわす|||

One of the cutouts will represent the number "3".

つまり 、 約 8万 個 ある 重み づけ を うまく 調整 し ない と 、 画像 の 「3」 を 見て 、 正しく 「3」 と 認識 でき ない のだ 。

|やく|よろず|こ||おもみ||||ちょうせい||||がぞう|||みて|まさしく||にんしき|||

In other words, if you don't adjust the approximately 80,000 weightings properly, you will get a "3" in the image. Look at the correct "3." They cannot recognize that they are not.

答え 合わせ を して 間違える たび に 重み づけ の 調整 を 繰り返して 、 認識 の 精度 を 上げて いく 学習 法 の 代表 的な もの を 「 誤差 逆 伝播 ( Back Propagation )」 と いう 。

こたえ|あわせ|||まちがえる|||おもみ|||ちょうせい||くりかえして|にんしき||せいど||あげて||がくしゅう|ほう||だいひょう|てきな|||ごさ|ぎゃく|でんぱ|back|propagation||

Answers A typical learning method that improves the accuracy of recognition by repeatedly adjusting the weighting each time a mistake is made is called “back propagation”.

どう 調整 する か と いう と 、 全体 の 誤差 ( 間違う 確率 ) が 少なく なる ように 微分 を とる 。

|ちょうせい||||||ぜんたい||ごさ|まちがう|かくりつ||すくなく|||びぶん||

The way to adjust is to take the derivative so that the overall error (probability of mistake) is reduced.

微分 を とる と いう の は 、 つまり 、 ある ひと つ の 重み づけ を 大きく する と 誤差 が 減る の か 、 小さく する と 誤差 が 減る の か を 計算 する と いう こと である 。

びぶん||||||||||||おもみ|||おおきく|||ごさ||へる|||ちいさく|||ごさ||へる||||けいさん|||||

Taking the derivative means calculating whether increasing the weighting of a person reduces the error, or decreasing it reduces the error.

そして 、 誤差 が 小さく なる 方向 に 、8万 個 の 重み づけ の それぞれ に 微 調整 を 加えて いく 。

|ごさ||ちいさく||ほうこう||よろず|こ||おもみ|||||び|ちょうせい||くわえて|

Then, in the direction of reducing the error, make fine adjustments to each of the 80,000 weights.

別な たとえ で 説明 する と 、 ある 組織 に おいて 上司 が 判断 を 下さ ない と いけない 場面 を 考えよう 。

べつな|||せつめい||||そしき|||じょうし||はんだん||くださ||||ばめん||かんがえよう

To use another analogy, consider a situation in an organization where a boss must make a decision.

上司 は 部下 から の 情報 を もと に 判断 を 下す 。

じょうし||ぶか|||じょうほう||||はんだん||くだす

The boss makes a decision based on the information from his subordinates.

自分 の 判断 が 正しかった とき は 、 その 判断 の 根拠 と なった 情報 を 上げて きた 部下 と の 関係 を 強め 、 判断 が 間違った とき は 、 間違い の 原因 と なった 情報 を 上げて きた 部下 と の 関係 を 弱める 。

じぶん||はんだん||ただしかった||||はんだん||こんきょ|||じょうほう||あげて||ぶか|||かんけい||つよ め|はんだん||まちがった|||まちがい||げんいん|||じょうほう||あげて||ぶか|||かんけい||よわめる

When your judgment is correct, strengthen the relationship with the subordinate who provided the information that was the basis of the judgment, and when the judgment was incorrect, the relationship with the subordinate who provided the information that caused the mistake. Weaken.

これ を 何度 も 繰り返せば 、 組織 と して 正しい 判断 を 下す 確率 が 上がって いく はずだ 。

||なんど||くりかえせば|そしき|||ただしい|はんだん||くだす|かくりつ||あがって||

Repeating this over and over again should increase the probability that the organization will make the right decisions.

つまり 、 正しい 判断 材料 が 下 ( 部下 ) から 上 ( 上司 ) へ 上がって いく 。

|ただしい|はんだん|ざいりょう||した|ぶか||うえ|じょうし||あがって|

In other words, the right materials for making decisions are transferred from the lower (subordinates) to the upper (supervisors).

一方 、 修正 を 加える とき は 、 先ほど と は 逆に 、 上 ( 上司 ) の 誤差 ( 判断 の 誤り ) から 出発 して 下 ( 部下 ) と の 関係 の 強 さ に 修正 を 加えて いく から 、 誤差 逆 伝播 と いう わけだ 。

いっぽう|しゅうせい||くわえる|||さきほど|||ぎゃくに|うえ|じょうし||ごさ|はんだん||あやまり||しゅっぱつ||した|ぶか|||かんけい||つよ|||しゅうせい||くわえて|||ごさ|ぎゃく|でんぱ|||

On the other hand, when making corrections, contrary to the previous case, starting from the error (misjudgment) of the upper (boss) and making corrections to the strength of the relationship with the lower (subordinates), the error back propagation That's why.

学習 フェーズ は 、1000 件 から 100万 件 ほど の 大量の データ を 入力 し 、 答え 合わせ を して 、 間違う たび に と を 適切な 値 に 修正 する と いう 作業 を ひたすら 繰り返す 。

がくしゅう|||けん||よろず|けん|||たいりょうの|でーた||にゅうりょく||こたえ|あわせ|||まちがう|||||てきせつな|あたい||しゅうせい||||さぎょう|||くりかえす

In the learning phase, a large amount of data, from 1000 to 1 million, is input, the answers are matched, and each mistake is corrected to an appropriate value.

8万 個 の 重み づけ を 修正 する ため に 、7万 枚 の 画像 を ひたすら 入力 し 続ける わけで 、 この 作業 に は とても 時間 が かかる 。

よろず|こ||おもみ|||しゅうせい||||よろず|まい||がぞう|||にゅうりょく||つづける|||さぎょう||||じかん||

This process is very time consuming, as we keep inputting 70,000 images in order to correct the 80,000 weighting.

通常 は 数 秒 から 、 長い とき は 数 日間 かかる こと も ある 。

つうじょう||すう|びょう||ながい|||すう|にち かん||||

Usually takes from a few seconds to several days in some cases.

しかし 、 いったん できて しまえば 、 使う とき は 簡単で 、 できあがった 重み づけ を 使って 、 これ まで の 訓練 用 データ と は 違う 新しい データ を 入力 して 、 出力 を 計算 する 。

||||つかう|||かんたんで||おもみ|||つかって||||くんれん|よう|でーた|||ちがう|あたらしい|でーた||にゅうりょく||しゅつりょく||けいさん|

Once it is done, however, it is easy to use it to calculate outputs by using the resulting weighting to input new data that is different from the training data.

この 作業 は 一瞬 で 終わる 。

|さぎょう||いっしゅん||おわる

This work is done in an instant.

1 枚 の 画像 に 対して 、 隠れ 層 を 計算 する ため の 簡単な 足し算 と 、 出力 層 を 計算 する ため の 簡単な 足し算 を する だけ な ので 、1 秒 も かから ない 。

まい||がぞう||たいして|かくれ|そう||けいさん||||かんたんな|たしざん||しゅつりょく|そう||けいさん||||かんたんな|たしざん||||||びょう|||

It takes less than a second to do a simple addition to calculate the hidden layer and a simple addition to calculate the output layer for a single image.

この 手書き の 文字 が 「3」 を 表す と わかる ように なる まで 、 生まれて から 数 年 かかる が 、 いったん わかって しまえば 、 次 から は 見た 瞬間 「 これ は 3 だ 」 と わかる 。

|てがき||もじ|||あらわす||||||うまれて||すう|とし||||||つぎ|||みた|しゅんかん|||||

It takes several years from birth until we can see that this handwritten letter represents "3", but once we know it, we can see "this is 3" from the next moment.

それ と 同じだ 。

||おなじだ

It's the same thing.

余談 に なる が 、 日本 は 高齢 化 社会 に なって きて おり 、 高齢 の 方 の 学習 能力 は 、 残念 ながら 若者 に 劣る 。

よだん||||にっぽん||こうれい|か|しゃかい|||||こうれい||かた||がくしゅう|のうりょく||ざんねん||わかもの||おとる

As an aside, Japan is becoming an aging society, and the learning ability of the elderly is unfortunately inferior to that of the young.

したがって 、 新しい こと を 学習 する の は 大変だ 。

|あたらしい|||がくしゅう||||たいへんだ

Therefore, learning new things is hard.

一方 で 、 判断 ・ 識別 する 能力 は 、 長い 年月 を かけて つくら れて おり 、 しかも 使う 際 に は 簡単に 早く 使う こと が できる 。

いっぽう||はんだん|しきべつ||のうりょく||ながい|ねんげつ|||||||つかう|さい|||かんたんに|はやく|つかう|||

On the other hand, the ability to judge and identify has been cultivated over many years, and when it is used, it can be used easily and quickly.

高齢 者 の 判断 ・ 識別 能力 を うまく 役立てて いく こと は 、 昔 で 言えば 老人 の 知恵 を 活 かす と いう こと だろう が 、 高齢 化 社会 に おいて 重要な こと かも しれ ない 。

こうれい|もの||はんだん|しきべつ|のうりょく|||やくだてて||||むかし||いえば|ろうじん||ちえ||かつ|||||||こうれい|か|しゃかい|||じゅうような||||

Judgment of the elderly ・ Making good use of identification ability may be to utilize the wisdom of the elderly in the old days, but it may be important in an aging society.

「 こういう やつ は 将来 伸びる 」 と か 、「 組織 が こう なる と 悪い 傾向 だ 」 など の 、 人間 や 組織 など の 時代 を 経て も 変わら ない もの を 見る 役割 と して 、 高齢 の 方 が 企業 の 会長 や 相談 役 に いる の は よく わかる 。

|||しょうらい|のびる|||そしき|||||わるい|けいこう||||にんげん||そしき|||じだい||へて||かわら||||みる|やくわり|||こうれい||かた||きぎょう||かいちょう||そうだん|やく||||||

Elderly people are the chairman of the company and the role of seeing things that have not changed over time, such as "these guys will grow in the future" and "the organization tends to be bad when this happens". I understand that you are a counselor.

判断 ・ 識別 能力 で 勝負 できる から である 。

はんだん|しきべつ|のうりょく||しょうぶ|||

The reason is that they can compete on the basis of their ability to judge and discriminate.

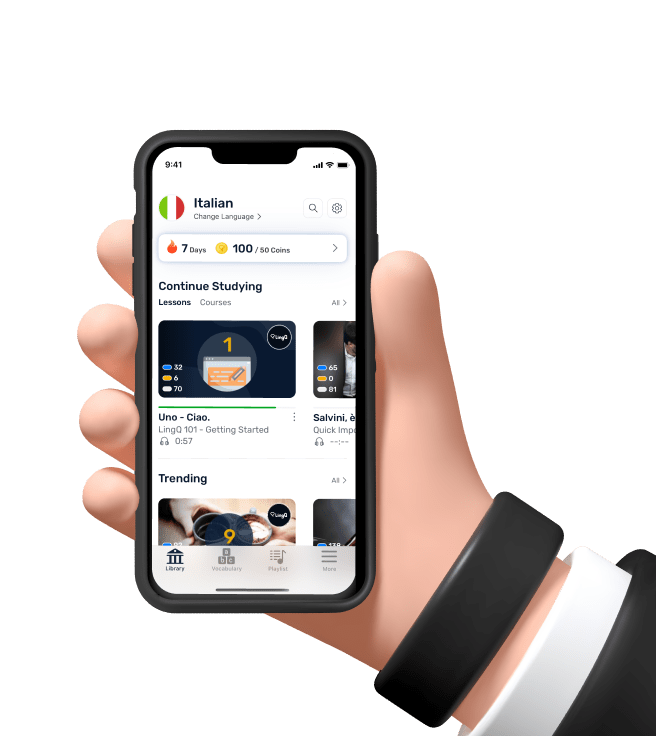

この 技術 は 、 ウェブ や ビッグ データ の 領域 で 広く 使わ れて いる 。

|ぎじゅつ||||びっぐ|でーた||りょういき||ひろく|つかわ||

This technology is widely used in the web and big data domains.

しかし 、 機械 学習 に も 弱点 が ある 。

|きかい|がくしゅう|||じゃくてん||

However, machine learning also has its weaknesses.

それ が フィーチャーエンジニアリング ( Feature engineering ) である 。

|||feature||

This is feature engineering.

つまり 、 特徴 量 ( あるいは 素性 と いう ) の 設計 であり 、 ここ で は 「 特徴 量 設計 」 と 呼ぼう (* 注 33)。

|とくちょう|りょう||すじょう||||せっけい|||||とくちょう|りょう|せっけい||よぼう|そそ

In other words, it is the design of features (or features), and here we will call it "feature design" (* Note 33).

特徴 量 と いう の は 、 機械 学習 の 入力 に 使う 変数 の こと で 、 その 値 が 対象 の 特徴 を 定量 的に 表す 。

とくちょう|りょう|||||きかい|がくしゅう||にゅうりょく||つかう|へんすう|||||あたい||たいしょう||とくちょう||ていりょう|てきに|あらわす

A feature quantity is a variable used for input in machine learning, and its value quantitatively expresses the feature of the target.

この 特徴 量 に 何 を 選ぶ か で 、 予測 精度 が 大きく 変化 する 。

|とくちょう|りょう||なん||えらぶ|||よそく|せいど||おおきく|へんか|

Depending on what is selected as the characteristic quantity, the accuracy of forecasting can vary greatly.

たとえば 、 手書き 文字 認識 で は 、 画像 の 中心 と 大き さ を 調整 して 特徴 量 を 設計 する 必要 が ある 。

|てがき|もじ|にんしき|||がぞう||ちゅうしん||おおき|||ちょうせい||とくちょう|りょう||せっけい||ひつよう||

For example, in handwriting recognition, you need to adjust the center and size of the image to design the features.

先ほど は 説明 を 単純 化 する ため に 触れ なかった が 、 ただ ピクセル 単位 に 分けて 読み 込ま せれば 精度 が 上がる わけで は ない のだ 。

さきほど||せつめい||たんじゅん|か||||ふれ|||||たんい||わけて|よみ|こま||せいど||あがる||||

I didn't mention it earlier to simplify the explanation, but it doesn't mean that the accuracy will be improved if it is read in pixel units.

特徴 量 を 何 に する か が 予測 精度 に 決定 的な 意味 を 持つ の は 、 年収 を 予測 する 問題 を 考えれば わかり やすい 。

とくちょう|りょう||なん|||||よそく|せいど||けってい|てきな|いみ||もつ|||ねんしゅう||よそく||もんだい||かんがえれば||

It is easy to understand that what the feature quantity should be has a decisive meaning for the prediction accuracy, considering the problem of predicting the annual income.

どこ に 住んで いる か 、 男性 か 女性 か 、 と いった 特徴 量 から 年収 を 予測 する と いう の は 、 ニューラルネットワーク や その他 の 機械 学習 の 方法 を 使って 学習 する こと が できる 。

||すんで|||だんせい||じょせい||||とくちょう|りょう||ねんしゅう||よそく||||||||そのほか||きかい|がくしゅう||ほうほう||つかって|がくしゅう||||

Predicting annual income from features such as where you live, male or female, can be learned using neural networks and other machine learning methods.

この とき 、 特徴 量 を 何 に する か 、 言い換える と 、 どんな 変数 を 読み 込ま せる か が 予測 精度 に 大きく 寄与 する こと は 容易に 想像 できる だろう 。

||とくちょう|りょう||なん||||いいかえる|||へんすう||よみ|こま||||よそく|せいど||おおきく|きよ||||よういに|そうぞう||

At this time, it is easy to imagine what the features should be, in other words, what variables should be read, which greatly contributes to the prediction accuracy.

図 18 に ある ように 、「 性別 」 や 「 居住 地域 」 は 年収 と 関係 が あり そうだ が 、「 身長 」 は 疑問 符 が つくし 、「 好きな 色 」 は それほど 関係ない はずだ 。

ず||||せいべつ||きょじゅう|ちいき||ねんしゅう||かんけい|||そう だ||しんちょう||ぎもん|ふ|||すきな|いろ|||かんけいない|

As shown in Figure 18, "gender" and "residential area" are likely to be related to annual income, but "height" is questionable and "favorite color" should not be so.

それ より は むしろ 、「 年齢 」 や 「 職業 」「 業種 」「 保有 する 資格 」 など の ほう が 年収 に 影響 する 可能 性 が 高い 。

||||ねんれい||しょくぎょう|ぎょうしゅ|ほゆう||しかく|||||ねんしゅう||えいきょう||かのう|せい||たかい

Rather, "age," "occupation," "industry," and "qualifications to hold" are more likely to affect annual income.

仮に 、 データベース に 「 誕生日 」 と いう 項目 が 入って いて も 、 それ だけ で は よい 特徴 量 で は ない 。

かりに|でーたべーす||たんじょうび|||こうもく||はいって||||||||とくちょう|りょう|||

Even if the database contains an item called "birthday", that alone is not a good feature.

誕生日 と 現在 の 日付 の 差 、 つまり 「 年齢 」 と いう 値 に して 初めて 年収 予測 問題 に 寄与 する ような 特徴 量 と なる 。

たんじょうび||げんざい||ひづけ||さ||ねんれい|||あたい|||はじめて|ねんしゅう|よそく|もんだい||きよ|||とくちょう|りょう||

The difference between the birthday and the current date, that is, the value of "age", is the first feature that contributes to the annual income forecasting problem.

ただ 、 こうした 判断 は コンピュータ に は でき ない 。

||はんだん||こんぴゅーた||||

However, a computer cannot make these decisions.

機械 学習 の 精度 を 上げる の は 、「 どんな 特徴 量 を 入れる か 」 に かかって いる のに 、 それ は 人間 が 頭 を 使って 考える しか なかった 。

きかい|がくしゅう||せいど||あげる||||とくちょう|りょう||いれる||||||||にんげん||あたま||つかって|かんがえる||

The accuracy of machine learning depends on "what features are included", but it can only be thought by humans using their heads.

これ が 「 特徴 量 設計 」 で 、 機械 学習 の 最大 の 関門 だった 。

||とくちょう|りょう|せっけい||きかい|がくしゅう||さいだい||かんもん|

This is "feature design." This was the biggest hurdle in machine learning.